🕐 ESTA REPORTAGEM FOI PUBLICADA EM Janeiro de 2024. INFORMAÇÕES CONTIDAS NESTE TEXTO PODEM ESTAR DESATUALIZADAS OU TEREM MUDADO.

Como ferramentas de IA podem ser usadas no combate à desinformação

Como ferramentas de IA podem ser usadas no combate à desinformação

“Desculpe, eu sou apenas um modelo de linguagem treinado e não consigo substituir o trabalho dos analistas do Radar Aos Fatos.” Apesar da humildade ao recusar os mais diversos e absurdos pedidos de usuários, o ChatGPT, produto mais famoso da OpenAI, foi base para uma bateria de testes feitos pela nossa equipe no último ano, que se preocupou em avaliar a capacidade da ferramenta de auxiliar no combate à desinformação.

A inteligência artificial generativa, capaz de aprimorar o próprio desempenho, é encarada com potencial tanto para salvar a humanidade como para destruí-la. A preocupação com o mau uso desse tipo de tecnologia fez, inclusive, com que seus próprios criadores propusessem mecanismos para regulá-las — isso enquanto consolidam suas posições no mercado e colhem os devidos lucros. No meio desse debate, cabe a nós colocar essas ferramentas à prova.

Em um esforço de meses que contou com a participação de várias mãos, pedimos ao modelo de linguagem que classificasse o conteúdo coletado pelos robôs do Radar Aos Fatos sobre o tema democracia ao longo do último ano em várias redes — as mensagens são as mesmas usadas para a elaboração do especial Golpeflix. Esse conteúdo, que já havia sido analisado sob a nossa metodologia (disponível aqui), foi reclassificado por nossa equipe de analistas e em seguida submetido à IA para que ela o examinasse sob o próprio ponto de vista.

A metodologia atual do Aos Fatos busca analisar os conteúdos avaliando-os em uma escala de 0 a 100 a partir de categorias textuais que indicam traços de discurso enganoso, desinformativo ou de baixa qualidade, como recorrência (conteúdos já checados anteriormente) ou toxicidade. Dessa forma, podemos trazer mais transparência às avaliações e, a partir de possíveis falhas, desenhar novas estratégias para melhorar o desempenho.

Assine já a newsletter do Radar Aos Fatos e receba a cada quinze dias técnicas de investigação com dados abertos

As categorias foram traduzidas para o modelo como zero-shot prompts — ou seja, sem oferecer nenhum exemplo previamente classificado. O objetivo era evitar uma classificação enviesada e permitir que a tecnologia trabalhasse em cima de um problema completamente novo.

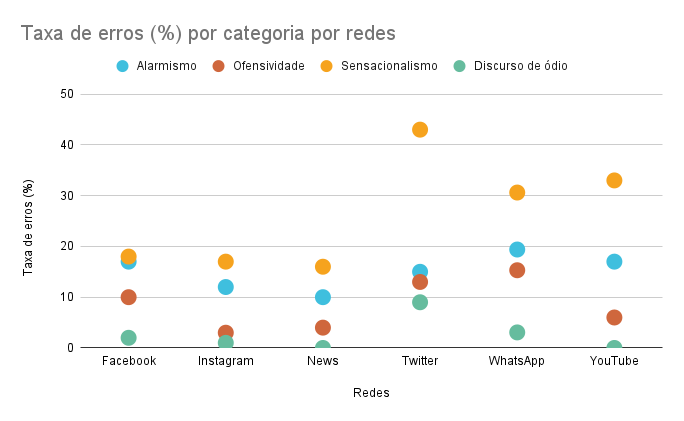

Em um primeiro momento, a partir de uma amostra aleatória de cem mensagens de texto coletadas de cada plataforma monitorada pelo Radar Aos Fatos, foi pedido ao ChatGPT que classificasse cada publicação em uma escala de 0 a 100 em quatro categorias subjetivas: Alarmismo, Ofensividade, Exagero ou Sensacionalismo e Discurso de Ódio.

A partir da classificação do modelo, definimos um limiar para transformar a escala em uma categoria binária, cujas respostas podem ser apenas “sim” ou “não”. Comparamos então esses resultados com o que consideramos o nosso padrão ouro: a de nossa equipe de analistas responsáveis pela metodologia do Radar Aos Fatos. A discrepância entre as classificações é ilustrada no gráfico abaixo:

Levando em consideração a experiência do teste anterior e contando com mais pesquisas em literatura especializada, pedimos que o modelo classificasse outra amostra aleatória, partindo de outras categorias que também podem ser úteis para identificar conteúdo desinformativo:

- a capacidade de manipular sentimentos;

- a toxicidade contida na mensagem;

- a existência de conteúdo violento;

- a probabilidade de ser uma mensagem fraudulenta ou spam;

- e o fato de o conteúdo da mensagem já ter sido checado de forma recorrente.

Apesar da tentação gerada pelos números, em um primeiro momento não foi possível aplicar essa metodologia em uma escala maior. Como o Radar Aos Fatos trabalha com um grande volume de conteúdos produzidos nas plataformas, com dezenas de milhares de posts por dia, a análise dos dados usando o modelo generativo poderia gerar boletos astronômicos (além de ser uma estratégia pouco sustentável).

Como, no entanto, modelos como esse têm evoluído rapidamente, inclusive com o lançamento de várias alternativas de código aberto, é possível que o uso da IA generativa no combate à desinformação se torne mais viável em um futuro próximo. Enquanto isso, outros produtos do Aos Fatos se beneficiam da tecnologia à sua maneira:

- Um deles é o Escriba, ferramenta que usa IA para transcrever áudios e conta com identificação de falantes. O recurso foi selecionado pela iniciativa Jogo Limpo e também foi finalista do prêmio Cláudio Weber Abramo em 2022;

- Mais recentemente, a FatimaBot, nossa robô checadora de fatos, passou a se chamar FatimaGPT e está passando por testes para incorporar o uso de recursos da inteligência artificial em canais no WhatsApp, no Telegram e em nosso site. O objetivo é que ela possa responder sobre peças desinformativas já checadas por nossa equipe.

Isso mostra que, a despeito das limitações atuais, não desistimos de usar essa tecnologia em nossas abordagens. Acompanhando as mudanças que ocorrem todos os dias, estamos avançando aos poucos e desenvolvendo produtos inovadores que possam contribuir para o debate público e garantir que a inteligência artificial auxilie no combate à desinformação.