🕐 ESTA REPORTAGEM FOI PUBLICADA EM Novembro de 2023. INFORMAÇÕES CONTIDAS NESTE TEXTO PODEM ESTAR DESATUALIZADAS OU TEREM MUDADO.

Conteúdos gerados por IA sobre Gaza podem colocar em dúvida veracidade de fotos reais

Imagens geradas por IA (inteligência artificial) retratando crianças em meio a guerra têm gerado dúvidas na análise sobre o que é real ou não no conflito entre Israel e Hamas. A dificuldade em confirmar a veracidade de conteúdos que circulam nas redes confunde até mesmo detectores de IA. Ao mesmo tempo, publicações que usam conteúdo artificial têm acumulado milhões de visualizações no Brasil.

Especialistas consultados por Aos Fatos enxergam a tendência com preocupação. Segundo eles, o uso indiscriminado da IA pode resultar em menos destaque para imagens reais e servir de pretexto para detratores colocarem em dúvida a credibilidade de imagens verdadeiras.

- Uma publicação no Facebook com imagem criada por IA, que mostra três crianças sorrindo em meio aos escombros e segurando uma bandeira da Palestina, superou 17,5 milhões de visualizações em apenas 24 horas. A ferramenta de monitoramento da Meta aponta que parte desse montante foi de visualizações pagas;

- Crianças chorando em meio ao cenário de destruição olhando para “a câmera” são retratadas no conteúdo artificial com frases que criam duplo sentido sobre a realidade, como “parem de matar inocentes” ou questionamentos de “estes são os terroristas do Hamas?”;

- Uma imagem gerada por IA que mostra um homem palestino resgatando cinco crianças tem circulado como se fosse verdadeira. Pernas e braços misturados e posicionamento das cabeças em locais estranhos são indícios de falhas nas ferramentas generativas;

- Os especialistas consultados pelo Aos Fatos opinam que as plataformas de IA generativa precisam ser responsabilizadas por permitir esse uso em contexto bélico;

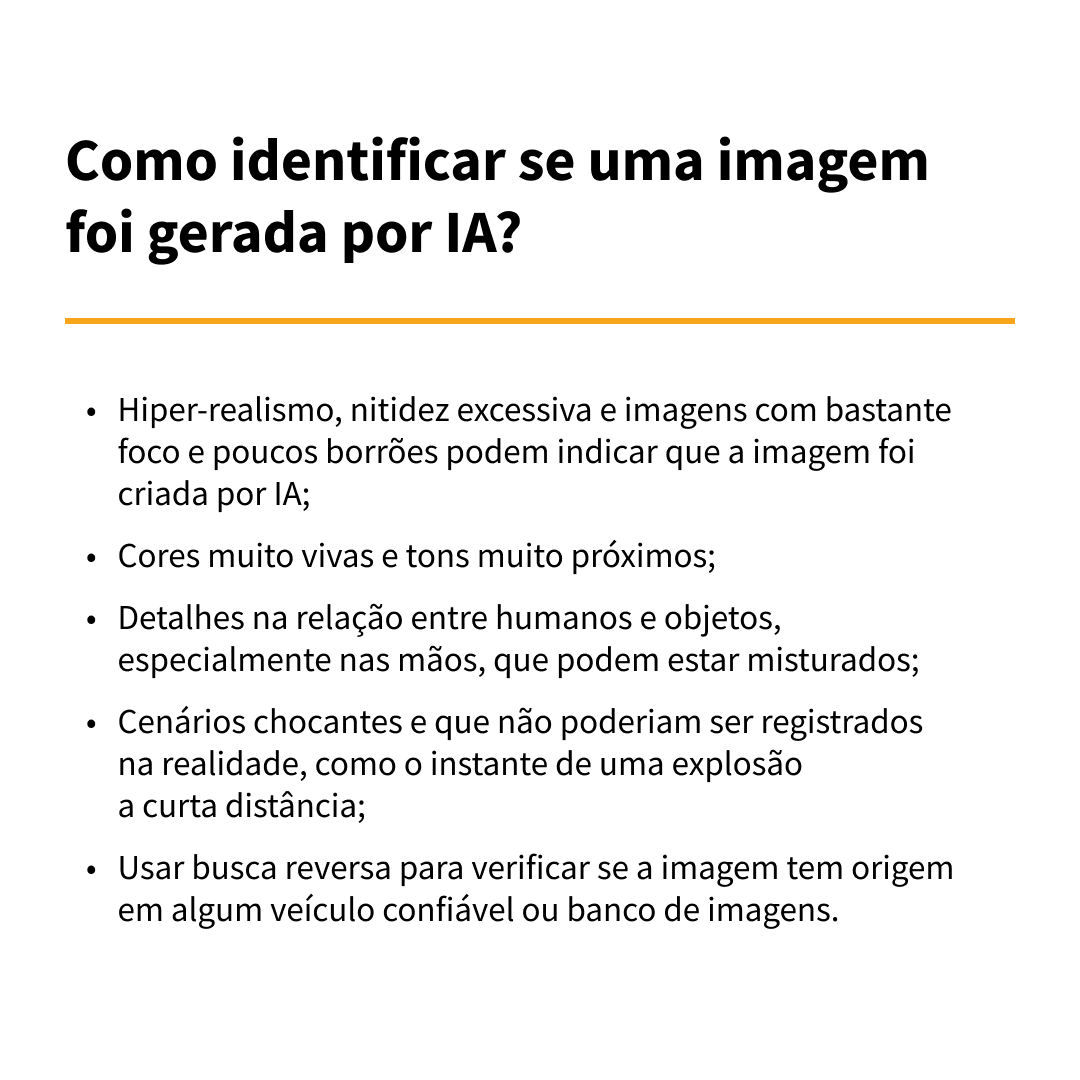

- Apesar das ferramentas estarem cada vez mais detalhistas, os especialistas apontam que detalhes como hiper-realismo, cores muito latentes, nitidez excessiva e sobreposição de elementos na imagem colaboram para identificar se a imagem é real ou manipulada.

Aos Fatos identificou que perfis pró-Palestina e pró-Israel têm compartilhado imagens de crianças em meio a escombros, sorrindo ou chorando, sendo carregadas por outras pessoas ou lamentando mortes - e que, no entanto, foram geradas por inteligência artificial.

Isso tem causado nos mais desavisados um impacto ainda maior diante do confronto no Oriente Médio. Ao menos quatro imagens foram identificadas pela reportagem e acumularam milhões de visualizações, de acordo com a ferramenta de monitoramento da Meta.

Os exemplos foram enviados ao especialista em análise forense de imagem e professor na Universidade da Califórnia em Berkeley Hany Farid, que confirmou que todas as imagens apresentavam características de imagens generativas.

“Todas as quatro imagens são classificadas com alto grau de confiança como geradas por IA. Além disso, cada uma das imagens tem pistas visuais reveladoras de serem geradas por IA”, concluiu.

Sobre o impacto dessas imagens hiper-realistas em publicações nas redes em um contexto de dificuldades de comunicação no território do conflito, Farid alertou para o potencial desinformativo dos conteúdos gerados por IA e o quanto isso poderia ser nocivo na disputa de narrativas em meio à guerra.

“Essas imagens são problemáticas por dois motivos. Primeiro, elas estão sendo usadas para espalhar informações potencialmente falsas. E em segundo lugar, e talvez de forma mais problemática, lançam uma sombra de dúvida sobre todas as imagens divulgadas, porque é fácil para os detratores afirmarem que as fotos reais são falsas”, ele aponta.

Rafael Sampaio, professor de ciência política da UFPR (Universidade Federal do Paraná) que estuda o uso de IA, defende que é necessário refletir sobre a responsabilização das plataformas que permitem gerar imagens com crianças em meio a contextos violentos.

“Talvez seja necessário dar um passo atrás. Não podemos esquecer, também, de responsabilizar as plataformas que geram essas imagens. Nesse contexto, gerar uma imagem de criança em guerra pode, sim, ser muito usado para desinformar”, ele comenta.

Desde o início do conflito, diversos vídeos e fotos foram tirados de contexto para desinformar. Embora existam receios sobre o uso da tecnologia generativa para produção de conteúdo enganoso em contexto bélico, pesquisadores alegam que o histórico de registros de violência tem sido mais explorado do que efetivamente imagens geradas por IA.

Apesar disso, ao menos duas publicações com fotos reais que registravam crianças israelenses e palestinas mortas foram colocadas em xeque, como se tivessem sido produzidas por inteligência artificial com o objetivo de chocar.

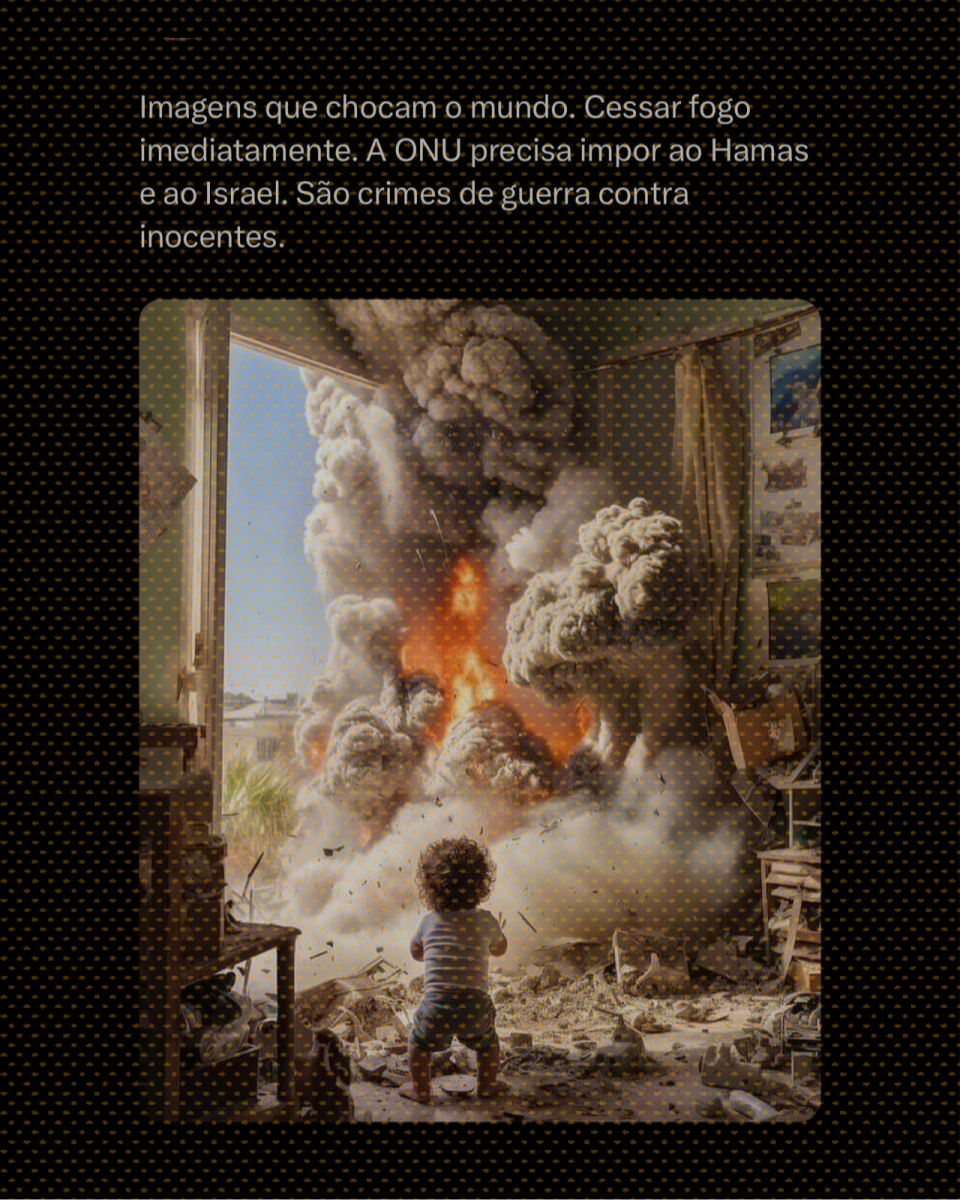

Na outra ponta, um deputado federal brasileirou usou, de fato, uma imagem gerada por IA como se fosse um registro real da guerra em uma postagem no X. Tanto o ângulo, como a própria cena, no entanto, não teriam base na realidade. Horas depois, o parlamentar apagou a publicação.

Os especialistas consultados por Aos Fatos destacam com preocupação os impactos de imagens criadas por inteligência artificial, por entrarem como parte de uma disputa que reforça estereótipos e preconceitos.

“O maior perigo é que essa questão imagética pode ficar muito guardada em nossa memória e às vezes é difícil desconstruir. Corrigir uma informação falsa tem um efeito muito pequeno, geralmente é lento, e as pessoas tendem a resistir à correção”, analisa Sampaio, professor da UFPR.

Pesquisador no INCT.DD (Instituto Nacional de Ciência e Tecnologia em Democracia Digital), na UFBA (Universidade Federal da Bahia), João Senna destacou que a evolução das tecnologias generativas tem criado algumas barreiras na diferenciação entre o que é imagem real ou não.

“O maior problema sobre a detecção de imagens geradas computacionalmente é que a tecnologia está evoluindo muito rápido, e os problemas que existiam nos modelos anteriores não são os mesmos dos modelos atuais”, ressalta o pesquisador. Segundo ele, problemas de múltiplas mãos e dedos extras em versões anteriores de algumas ferramentas, como Dall-E e Stable diffusion, já foram mitigados nas atuais.

Senna também ressalta a movimentação para regulamentar uma assinatura digital que deve ser aplicada a conteúdos gerados por IA. Mesmo não sendo perceptível aos olhos humanos ela poderá ser checada por computadores, conforme a Casa Branca definiu que seja feito nos Estados Unidos.

Referências:

1. 404 Media

2. CNN Brasil

3. Poynter

4. Wired

5. Aos Fatos

6. Politico